Em 2020, o filósofo baseado em Oxford, Toby Ord, publicou um livro chamado The Precipice sobre o risco de extinção humana. Ele colocou as chances de “catástrofe existencial” para nossa espécie durante o próximo século de uma em seis.

É um número bastante específico e alarmante. A afirmação gerou manchetes na época e tem sido influente desde então – mais recentemente mencionada pelo político australiano Andrew Leigh em um discurso em Melbourne.

É difícil discordar da ideia de que enfrentamos perspectivas preocupantes nas próximas décadas, como as mudanças climáticas, armas nucleares e patógenos bioengenheirados (todos grandes problemas em minha opinião), além de IA descontrolada e asteroides grandes (que eu consideraria menos preocupantes).

Mas e esse número? De onde ele vem? E o que ele realmente significa?

Arremessos de moedas e previsões meteorológicas

Para responder a essas perguntas, precisamos responder a outra primeiro: o que é probabilidade?

"A visão mais tradicional da probabilidade é chamada de frequentismo e deriva seu nome de sua herança em jogos de dados e cartas. Nessa visão, sabemos que há uma chance em seis de um dado justo mostrar um três (por exemplo), observando a frequência de três em um grande número de lançamentos.

Ou considere o caso mais complicado das previsões meteorológicas. O que significa quando um meteorologista nos diz que há uma chance de um em seis (ou 17%) de chuva amanhã?

É difícil acreditar que o meteorologista queira que imaginemos uma grande coleção de “amanhãs”, dos quais alguma proporção experimentará precipitação. Em vez disso, precisamos olhar para um grande número de tais previsões e ver o que aconteceu depois delas.

Se o previsor for bom em seu trabalho, deveríamos ver que, quando ele disse “uma chance de um em seis de chuva amanhã”, choveu de fato no dia seguinte uma vez a cada seis vezes.

Portanto, a probabilidade tradicional depende de observações e procedimentos. Para calculá-la, precisamos ter uma coleção de eventos repetidos nos quais basear nossa estimativa.

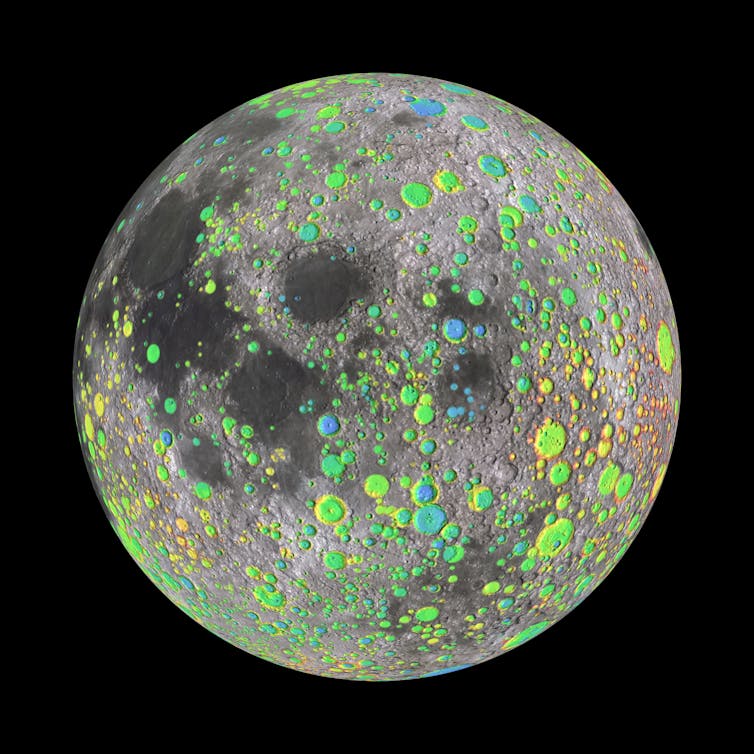

Podemos aprender com a Lua?

Então, o que isso significa para a probabilidade de extinção humana? Bem, esse evento seria único: depois que acontecesse, não haveria espaço para repetições.

Em vez disso, podemos encontrar alguns eventos paralelos para aprender. De fato, no livro de Ord, ele discute uma série de eventos potenciais de extinção, alguns dos quais podem ser examinados à luz da história.

Por exemplo, podemos estimar as chances de um asteroide do tamanho da extinção atingir a Terra examinando quantas rochas espaciais desse tipo atingiram a Lua ao longo de sua história. Um cientista francês chamado Jean-Marc Salotti fez isso em 2022, calculando as chances de um impacto de nível de extinção no próximo século em cerca de uma em 300 milhões.

Claro, essa estimativa é repleta de incertezas, mas é respaldada por algo que se aproxima de um cálculo de frequência adequado. Ord, por outro lado, estima o risco de extinção por asteroide em uma em um milhão, embora ele observe um grau considerável de incerteza.

Um sistema de classificação para resultados

Há outra maneira de pensar sobre probabilidade, chamada de Bayesianismo, em homenagem ao estatístico inglês Thomas Bayes. Isso se concentra menos nos eventos em si e mais no que sabemos, esperamos e acreditamos sobre eles.

Em termos muito simples, podemos dizer que os bayesianos veem probabilidades como uma espécie de sistema de classificação. Nessa visão, o número específico atribuído a uma probabilidade não deve ser considerado diretamente, mas sim comparado a outras probabilidades para entender quais resultados são mais ou menos prováveis.

O livro de Ord, por exemplo, contém uma tabela de eventos potenciais de extinção e suas estimativas pessoais de probabilidade. De uma perspectiva bayesiana, podemos ver esses valores como classificações relativas. Ord acredita que a extinção devido a um impacto de asteroide (uma em um milhão) é muito menos provável do que a extinção devido às mudanças climáticas (uma em mil), e ambas são muito menos prováveis do que a extinção devido ao que ele chama de “inteligência artificial não alinhada” (uma em dez).

A dificuldade aqui é que as estimativas iniciais de probabilidades bayesianas (frequentemente chamadas de “prioris”) são bastante subjetivas (por exemplo, eu classificaria a chance de extinção baseada em IA muito mais baixa). O raciocínio bayesiano tradicional passa de “prioris” para “posteriores” incorporando novamente evidências observacionais de resultados relevantes para “atualizar” os valores de probabilidade.

E mais uma vez, os resultados relevantes para a probabilidade de extinção humana são escassos.

Estimativas subjetivas

Há duas maneiras de pensar sobre a precisão e utilidade dos cálculos de probabilidade: calibração e discriminação.

Calibração é a correção dos valores reais das probabilidades. Não podemos determinar isso sem informações observacionais apropriadas. A discriminação, por outro lado, refere-se apenas às classificações relativas.

Não temos uma base para pensar que os valores de Ord estão devidamente calibrados. Claro, isso provavelmente não é sua intenção. Ele indica que eles são principalmente projetados para dar indicações de “ordem de magnitude”.

Mesmo assim, sem nenhuma confirmação observacional relacionada, a maioria dessas estimativas permanece simplesmente no domínio subjetivo das probabilidades anteriores.

Não bem calibrado – mas talvez ainda útil

Então, o que devemos fazer com “uma em seis”? A experiência sugere que a maioria das pessoas tem um entendimento menos do que perfeito da probabilidade (como evidenciado, entre outras coisas, pela venda contínua de bilhetes de loteria). Nesse ambiente, se você está fazendo um argumento em público, uma estimativa de “probabilidade” não precisa necessariamente estar bem calibrada – ela só precisa ter o tipo certo de impacto psicológico.

- Veja também: Úteros artificiais se aproximam de testes em humanos

Do meu ponto de vista, “uma em seis” se encaixa perfeitamente. “Uma em 100” pode parecer pequeno o suficiente para ser ignorado, enquanto “uma em três” pode causar pânico ou ser descartado como discurso apocalíptico.

Como uma pessoa preocupada com o futuro, espero que riscos como as mudanças climáticas e a proliferação nuclear recebam a atenção que merecem. Mas como cientista de dados, espero que o uso descuidado da probabilidade seja deixado de lado e substituído pela educação generalizada sobre seu verdadeiro significado e uso apropriado.

Steven Stern , professor de ciência de dados, Bond University.

Este artigo foi republicado do The Conversation sob uma licença Creative Commons. Leia o artigo original.